Организация пространственной группировки сигналов в ассоциативных процессах искусственных нейронных сетей

Аннотация

Дата поступления статьи: 26.12.2013В статье рассматриваются вопросы связанные с разработкой оптимальной структуры нейронных сетей. Одной из важнейших проблем, при синтезе нейроконтроллеров является обеспечение оптимального количества нейронов и соотношения связей между слоями сети. Необходимо добиться компромисса между представительскими возможностями сети, и объёмом памяти, который потребуется для её хранения. В статье приводится ряд эвристических правил, позволяющий достичь подобного компромисса за счет ограничения количества связей каждого нейрона.

Ключевые слова: нейронные сети, нейроконтроллер, ассоциативная память, машинное обучение, оптимизация

05.13.01 - Системный анализ, управление и обработка информации (по отраслям)

Введение

Применяя искусственные нейронные сети для решения практических задач, приходится сталкиваться с рядом затруднений. Эти затруднения вызваны отсутствием четких алгоритмов действий (инструкций), для некоторых важных этапов создания структуры сети. В литературных источниках, как правило, приводятся лишь общие эвристические указания, позволяющие в той или иной степени упростить решение задачи [1,2]. Таковыми, например, являются выбор количества нейронов в слое, а также определение топологии связей между нейронами соседних слоёв. Классический подход заключается в задании полносвязной конической структуры, в которой количество нейронов в каждом последующем слое меньше чем в предыдущем, а каждый нейрон слоя связан со всеми нейронами предыдущего слоя. В статье даётся определение пространственной группировки сигнала, при передаче между слоями сети, а также приводятся рекомендации, позволяющие выбрать структуру и топологию связей между слоями.

Ассоциативная память на основе искусственной нейронной сети

Ключевой характеристикой отличающей нейронные сети от прочих вычислительных алгоритмов является распределённый и ассоциативный способ сохранения информации. Свойство ассоциативности означает, что образы, помещаемые в память сети, сохраняются по принципу «ключ-значение». При этом ключевой образ также содержит в себе адрес сохранённого образа. Математически это записывается как отображение вида

![]() ,

,

где ![]() – ключевой образ,

– ключевой образ, ![]() – запомненный образ, q – количество хранимых в сети образов.

– запомненный образ, q – количество хранимых в сети образов.

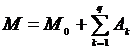

Распределённость реализуется благодаря хранению информации в синапсах [3]. Поскольку образы, с которыми работает сеть, представлены в виде векторов (обычно используется одномерный вектор элементами которого являются действительные числа), то память сети выглядит как ассоциативная матрица, в элементах которой сохраняется распределённое представление входного образа

![]() ,

,

где ![]() – ассоциативная матрица для k-го образа. Эта матрица может быть выражена через произведение векторов ключевого и запоминаемого образов

– ассоциативная матрица для k-го образа. Эта матрица может быть выражена через произведение векторов ключевого и запоминаемого образов

![]() (1)

(1)

Процесс обучения сети описывается в рекурсивном виде следующим образом

![]() , (2)

, (2)

где ![]() – матрица памяти сети после добавления k-го образа.

– матрица памяти сети после добавления k-го образа.

Исходная матрица ![]() является нулевой (или инициированной случайными малыми значениями), а итоговая матрица памяти описывается выражением

является нулевой (или инициированной случайными малыми значениями), а итоговая матрица памяти описывается выражением

(3)

(3)

Учитывая, что ![]() и

и ![]() векторы, выражение (2) принимая во внимание выражение (1) можно переписать в следующем виде

векторы, выражение (2) принимая во внимание выражение (1) можно переписать в следующем виде

![]()

Здесь матрица памяти ![]() представляет собой оценку матрицы памяти до введения в неё нового k-го образа, а

представляет собой оценку матрицы памяти до введения в неё нового k-го образа, а ![]() , соответственно, обновлённую оценку, с учетом новой информации, введённой в сеть. На этом принципе основывается метод перманентного обучения, при котором каждый новый факт (образ) поступивший в сеть изменяет её структуру, тем самым оказывая влияние на все последующие информационные процессы, протекающие в сети. При перманентном обучении в жизненном цикле сети отсутствует отдельно выделенный этап обучения, за исключением предобучения, обеспечивающего опорные реакции сети на наиболее типичные входные образы.

, соответственно, обновлённую оценку, с учетом новой информации, введённой в сеть. На этом принципе основывается метод перманентного обучения, при котором каждый новый факт (образ) поступивший в сеть изменяет её структуру, тем самым оказывая влияние на все последующие информационные процессы, протекающие в сети. При перманентном обучении в жизненном цикле сети отсутствует отдельно выделенный этап обучения, за исключением предобучения, обеспечивающего опорные реакции сети на наиболее типичные входные образы.

Извлечение информации из ассоциативной памяти

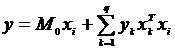

Поскольку входной вектор одновременно является и ключом и адресом сохранённого в памяти образа, то для извлечения данных необходимо подать изначальный ключевой образ на вход сети [4,5]. Пусть на вход сети подаётся входной образ ![]() , и предполагается, что отклик сети должен составить некоторый образ y, соответствующий изначальному ключевому образу. Математическая запись этого предположения будет иметь вид

, и предполагается, что отклик сети должен составить некоторый образ y, соответствующий изначальному ключевому образу. Математическая запись этого предположения будет иметь вид

![]()

Используя выражения (1) и (3) можно переписать эту запись иначе

(4)

(4)

Если предположить что исходная матрица была нулевой, то первое слагаемое обращается в ноль, и его можно не учитывать в дальнейших рассуждениях. Кроме того поскольку ![]() является скалярным произведением выражение (4) можно переписать в виде

является скалярным произведением выражение (4) можно переписать в виде

(5)

(5)

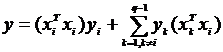

В дальнейшем можно предположить, что ключевые образы нормализованы, т.е.

![]() (6)

(6)

Тогда выражение (5) можно записать так

![]() , (7)

, (7)

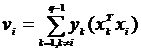

где

(8)

(8)

Первое слагаемое определяет ожидаемый выходной вектор, который был сохранён на этапе обучения в памяти сети. Второе слагаемое, вектор ![]() , определяет шум, возникающий при смешивании ключевого образа

, определяет шум, возникающий при смешивании ключевого образа ![]() с прочими образами, сохранёнными в сети. Этот вектор определяет ошибки, которые совершает сеть при извлечении информации из памяти.

с прочими образами, сохранёнными в сети. Этот вектор определяет ошибки, которые совершает сеть при извлечении информации из памяти.

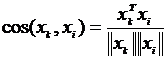

Если рассматривать множество входных сигналов как линейное пространство [6], то из скалярного произведения входных векторов можно выразить косинус угла между ними

В соответствии с условием (6) можно упростить это выражение

![]()

и переписать выражение (8) в новом виде

Данное выражение обращается в ноль, если значение косинуса будет равно нулю. Это условие соблюдается, если все ключевые вектора являются ортогональными (перпендикулярными друг другу в Евклидовом смысле). В этом случае реальный отклик сети y согласно выражению (7) будет равен исходному запомненному вектору ![]() . Если ключевые векторы выбираются из ортогонального набора, то память, сформированная с их помощью называется совершенно ассоциативной. Сложность создания совершенно ассоциативной памяти заключается в том, что представители двух различных классов объектов могут иметь не ортогональные ключевые векторы [7,8].

. Если ключевые векторы выбираются из ортогонального набора, то память, сформированная с их помощью называется совершенно ассоциативной. Сложность создания совершенно ассоциативной памяти заключается в том, что представители двух различных классов объектов могут иметь не ортогональные ключевые векторы [7,8].

Степень ортогональности может быть оценена при помощи Евклидова расстояния. В силу выражения (6) Евклидово расстояние для ортогональных нормализованных векторов будет равно 0.

Пространственная группировка

Для того чтобы дать описание понятию пространственной группировки сигнала необходимо рассмотреть участок сети из двух нейронных слоёв связанных друг с другом. Если обозначить количество нейронов в первом слое через I, а количество нейронов во втором слое (принимающем сигнал от первого) через O, то возможны три ситуации: O = I, O< I, I< O. Сети в которых количество нейронов принимающего слоя больше, чем количество нейронов передающего слоя в классических нейронных сетях не рассматриваются [9,10]. Однако подобная избыточность может быть полезна, при формировании в памяти сети временных зависимостей или так называемой временной группировки данных.

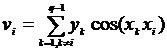

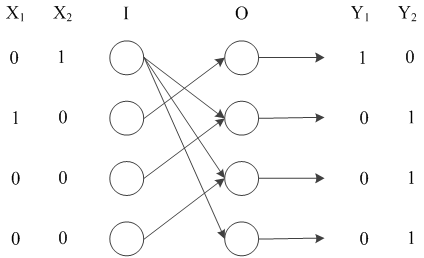

Если количество нейронов в обоих слоях одинаково, такая сеть может рассматриваться как кодирующая [11]. Очевидно, что в такой ситуации мощности входного множества сигналов и выходного одинаковы, поэтому сеть по существу выполняет равномощное отображение одних сигналов в другие. Подобные отображения могут представлять интерес для формирования ортогональных представлений изначально неортогональных сигналов. Рисунок 1 иллюстрирует простейший случай подобного использования одинаковых по мощности слоёв (на рисунке представлены только значимые в контексте описания связи).

Рис. 1. – Пример использования пространственной группировки для разделения неортогональных сигналов

Проведённые указанным способом связи позволяют сформировать для не ортогональных векторов ![]() и

и ![]() полностью ортогональные представления

полностью ортогональные представления ![]() и

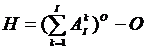

и ![]() . Ортогональность для бинарных сетей может быть оценена при помощи расстояния Хемминга

. Ортогональность для бинарных сетей может быть оценена при помощи расстояния Хемминга

![]() ,

,

где i и j – индексы сравниваемых векторов, p – мощность векторов i и j.

Для ортогональных векторов оно будет равно p.

Наибольший же интерес представляет ситуация, при которой I > O. В этой ситуации отображение выполняемое сетью следует рассматривать как перевод входного вектора в вектор пространства признаков [6,12]. По существу происходит сжатие информации, поскольку результирующий вектор имеет меньшую мощность, чем изначальный вектор сигнала.

Пространственной группировкой передаваемого сигнала называется распределение активности нейронов принимающего сигнал слоя. Важнейшим свойством пространственной группировки является независимость топологического расположения активных нейронов двух соседних слоёв. Это позволяет организовывать независимую обработку изначально схожих образов, и делает возможным отнесение близких (в смысле расстояния Хэмминга) векторов, к разным классам.

Ключевыми характеристиками, определяющими качество пространственной группировки, являются:

- Радиус охвата нейрона (R) – это количество нейронов предыдущего слоя, связанных с одним нейроном текущего слоя. При классическом подходе R = I, однако, полносвязность нейрона с предыдущим слоем существенно замедляет сходимость алгоритмов обучения. Кроме того, в некоторых случаях это может приводить к сужению потенциального количества классов отображения. Такая ситуация может возникать при чрезмерной перетренированности сети [13,14]. Снижая радиус охвата можно добиться более оптимального использования памяти (путём уменьшения количества синапсов), и устранить эффект перетренированности. Однако при применении этой характеристики следует учитывать тот факт, что радиус охвата прямо пропорционален способности сети к пространственной группировке сигнала.

- Плотность соединения (P) – в классическом подходе предполагается, что плотность равна 100%, однако при работе с большими слоями и значительными радиусами имеет смысл определить случайную функцию распределения, которая определит плотность связей внутри радиуса. Экспериментально установлено, что оптимальным является значение в 80%. Это означает, что внутри радиуса охвата каждого нейрона реально установленными должны быть лишь 80% связей.

Число способов, которыми можно распределить связи между слоями значительно

,

,

где ![]() – число сочетаний из I по k элементов. Из полученного результата нужно вычесть O чтобы убрать бессмысленный вариант (приходящийся по одному на каждый нейрон принимающего слоя) при котором нейрон не связан ни с одним нейроном передающего слоя.

– число сочетаний из I по k элементов. Из полученного результата нужно вычесть O чтобы убрать бессмысленный вариант (приходящийся по одному на каждый нейрон принимающего слоя) при котором нейрон не связан ни с одним нейроном передающего слоя.

При выборе структуры сети необходимо тщательно проанализировать топологические закономерности в сигналах обучающей выборки и определить наиболее оптимальный радиус и плотность соединения нейронов друг с другом. Дальнейшая работа будет направлена на всестороннее рассмотрение этого вопроса и определение точных функциональных закономерностей, которые бы позволяли бы точно рассчитать указанные параметры слоёв.

Заключение

Несмотря на то, что пока не удаётся определить чёткую функциональную зависимость, позволяющую рассчитать оптимальную структуру создаваемой нейронной сети, тем не менее приведённые рекомендации позволяют подойти к выбору этой структуры более осознанно. Очевидно, что пространственная группировка сигнала играет важную роль в процессах переработки информации в биологических нейронных сетях [15, 16]. Широко известно, что локализация обработки сигналов в мозгу носит крайне относительный характер, и становится практически не различимой при попытках анализировать её на глубинных этапах, которые отвечают за формирование высших нервных функций.

Работа выполнена при поддержке РФФИ (проект № 13-07-00951).

Литература:

- Фролов, Ю.В. Интеллектуальные системы и управленческие решения [Текст] / Ю.В. Фролов — М.: МГПУ, 2000. — 294 c.

- Perceptrons / Minsky M. L., Papert S. A.. — Cambridge: MIT Press, 1969. — 258 c.

- McCulloch W.S., Pitts W., "A logical calculus of the ideas immanent in nervous activity," Bulletin of mathematical biophysics, Том 5, 1943. — c. 115 - 133.

- Бессмертный, И.А. Искусственный интеллект [Текст] / И.А. Бессмертный — СПб: СПбГУ ИТМО, 2010. — 132 с.

- Andersen J.A. “A simple neural network generating an interactive memory”, Mathematical Biosciences, 1972, vol. 14, p. 197-220.

- Хайкин, Саймон Нейронные сети: полный курс, 2nd ed. /C. Хайкин — М.: Вильямс, 2006. — 1104 c.

- Д.В. Маршаков, О.Л. Цветкова, А.Р. Айдинян Нейросетевая идентификация динамики манипулятора [Электронный ресурс] // «Инженерный вестник Дона», 2011, №3. – Режим доступа: http://www.ivdon.ru/magazine/archive/n3y2011/504 (доступ свободный) – Загл. с экрана. – Яз. рус.

- В.В. Воронин, Р.А. Сизякин, Н.В. Гапон, В.А. Франц, А.Ю. Колосов Алгоритм реконструкции изображений на основе анализа локальных бинарных окрестностей [Электронный ресурс] // «Инженерный вестник Дона», 2013, №3. – Режим доступа: http://www.ivdon.ru/magazine/archive/n3y2013/1857 (доступ свободный) – Загл. с экрана. – Яз. рус.

- Бодянский, Е.В. Искусственные нейронные сети: архитектуры, обучение, применение [Текст] / Е.В. Бодянский, О.Г Руденко. — М.: Питер, 2008.— 362 c.

- Амосов, Н.М. Автоматы и разумное поведение [Текст] / Н.М. Амосов , А.М. Касаткин, Л.М. Касаткина, С.А. Талаев — Киев: Наукова думка, 1973. — 365c.

- Горбань, А.Н., Нейроинформатика [Текст] / А.Н. Горбань, В. Л. Дунин-Барковский, Е. М. Миркес и др. — Новосибирск: Наука, 1998. – 160 с.

- Галушкин, А.И. Теория нейронных сетей [Текст] / А.И. Галушкин – М.: ИПРЖР, 2000. – 416 с.

- Ротштейн, А.П. Интеллектуальные технологии идентификации: нечеткие множества, генетические алгоритмы, нейронные сети [Текст] / А.П. Ротштейн – Винница: УНІВЕРСУМ-Вінниця, 1999. – 320 с.

- Hartman E.J., Keeler J.D., Kowalski J. Layered neural networks with Gaussian hidden units as universal approximations // Neural Computation. – 1990. – 2. – P. 210-215.

- Cooper L.N. “A possible organization of animal memory and learning”, Proceedings of the Nobel Symposium on Collective Properties of Physical Systems, B, Lundquist and S.Lunquist, eds., New York: Academic Press 1973, p 252-264.

- Эдельмен, Дж. Разумный мозг [Текст] / Дж. Эдельмен, В. Маунткасл; Е.Н. Соколов —М.: МоскваМир, 1981. — c. 135.